Google段落索引可以利用BERT吗?

自Google宣布在生产搜索中进行名为BERT的新更新以来已经过去了12个月,最近的Search On事件也就不足为奇了,几乎是在生产BERT的第一个生日前夕,其中包括关于AI的巨大进步和突破的大量讨论。 BERT在过去的一年中。

BERT是什么的回顾

概括地说,Google BERT 2019年10月更新是一个机器学习更新,旨在帮助Google更好地理解查询和内容,通过更好地理解“词的含义”(上下文)来消除多义词中的细微差别。 最初的更新仅影响了10%的英语查询以及出现的地区中的精选摘要。

重要的是,最初的BERT搜索更新主要是为了消除歧义,以及特色片段中的文本提取和汇总。 消歧方面主要应用于句子和短语。

在BERT的产品搜索公告发布后的一个月左右,便开始向更多国家/地区推广,尽管仍仅影响所有地区10%的查询。

最初,2019年10月的公告在SEO领域引起了不小的轰动,尤其是因为谷歌在宣布BERT时表示,该更新代表了``过去五年中最大的飞跃,也是历史上最大的飞跃之一搜索。”

这显然是自RankBrain以来最重要的公告,而且毫不夸张-不仅是对于Web搜索领域。 在过去的12个月中,自然语言理解领域(半个世纪的研究领域)中与BERT相关的发展,可以说使学习比过去50年的总和前进了更多。

原因是另一个BERT-Google研究人员Devlin等人在2018年发表的一篇学术论文,标题为“ BERT:深度双向变压器的预训练,以进行语言理解。” 注意,我将在这里参考几篇学术论文。 您将在本文末尾找到来源和资源列表。

BERT(论文)随后被开源,供机器学习社区中的其他人在此基础上进行开发,毫无疑问,它为世界上戏剧性的计算语言学的理解做出了巨大贡献。

BERT的基本思想是,使用变体“注意”机制对来自大型文本**(En Wikipedia和BookCorpus)中单词的上下文窗口进行双向预训练,以便查看左侧和右侧的所有单词。同时在滑动上下文窗口中找到目标的右侧,以获得更大的上下文。

一旦受过训练,BERT便可以用作基础,然后在其他更细粒度的任务上进行微调,其中许多研究重点在于下游自然语言的理解,问题和答案。

澄清“词义”的“上下文窗口”的示例

由于上下文窗口的范围是一个重要概念,因此我提供了一个示例进行说明:

如果上下文窗口长10个单词,并且目标单词在10个单词的滑动“上下文窗口”中位于位置6,则BERT不仅可以看到左侧的1-5个单词,还可以看到右侧的7-10个单词同时二次使用注意力“单词对”。

这是一个很大的进步。 以前的模型是单向的,这意味着它们只能看到左侧的1-5个单词,而看不到7-10个单词,直到它们在滑动窗口中到达这些单词为止。 使用这种双向性质和同时注意,可以为给定单词提供完整的上下文(当然,在窗口长度的限制内)。

例如,如果上下文窗口中的其他单词也包括“河流”或“金钱”,则对“银行”一词的理解有所不同。 上下文窗口中的同时出现的单词增加了含义,突然将“银行”理解为“金融银行”或“河岸”。

返回2019年10月Google BERT更新公告

2019年10月25日,产品搜索公告宣布了语言研究界对于BERT的狂热关注。

在2018年至2019年期间,出现了各种芝麻街角色,名为BERT型模型,包括百度的ERNIE。 Facebook和Microsoft也在忙于构建类似BERT的模型,并在每个转弯处都在BERT上进行改进。 Facebook声称他们的ROBERTA模型只是BERT训练更强大的版本。 (微软表示自2019年4月以来一直在Bing中使用BERT,)

大型技术AI团队在各种机器学习语言任务排行榜中相互超越,其中最受欢迎的是SQuAD(斯坦福问答数据集),GLUE(通用语言理解评估)和RACE(评估中的阅读理解); 击败人类语言理解基准。

但是到2020年呢?

尽管SEO世界在BERT话题上一直保持沉默(直到本月),但对BERT周围的深度学习和自然语言处理世界的热情有所提高,而不是在2020年减弱。

2019年/ 2020年AI和自然语言理解的发展绝对应该使SEO再次完善其BERT跟踪游戏。 特别是考虑到本周的发展,尤其是在Google的Search On在线活动发布公告之后。

BERT并不总是表示“ BERT”

我们继续之前的重要注意事项:

“像BERT一样” —一种描述性术语,用于在“语言”上预先训练大型的未标记文本模型,然后使用通过转换器技术进行的传递学习来利用一系列更细化的任务对模型进行微调。

尽管2019年的Google更新被称为BERT,但它更可能是指现在在搜索的部分内容和机器学习语言领域中整体使用的方**,而不是每个字眼都进行一次算法更新,因为BERT和BERT甚至在2019年也是如此在机器学习语言世界中几乎被称为形容词。

在搜索公告中返回Google的AI

“随着AI的最新发展,与过去十年相比,我们在Google的改进方面取得了更大的进步,因此,您更容易找到自己想要的东西,” Prabhakar Raghavan在最近的搜索活动。

而且他并不夸张,因为Google揭示了一些令人兴奋的新功能即将推出,包括对拼写错误算法,会话代理,图像技术的改进以及对Google Assistant的嗡嗡声。

BERT使用方面也有重大新闻。 使用率从仅10%的查询到几乎所有英语查询的使用都大大增加。

“今天,我们很高兴分享BERT,现在几乎所有英语查询中都使用了BERT,可帮助您获得更高质量的问题结果。”

(Prabhakar Raghavan,2020年)

段落索引

除了BERT使用扩展消息之外,还有另一项公告特别使SEO世界陷入了疯狂。

Google会通过“段落索引”这一主题,对某些查询做出响应,从而对部分页面和文档中的特定段落进行排名和显示。

Google的Raghavan解释说:

“非常具体的搜索可能很难做到正确,因为有时回答您问题的单个句子可能会被深埋在网页中。 我们最近在排名方面取得了突破,现在不仅可以索引网页,还可以索引页面中的各个段落。 通过更好地理解特定段落的相关性,而不仅仅是整个页面,我们可以找到您正在寻找的“大海捞针”信息。 随着我们在全球范围内推广,这项技术将改善所有语言的7%的搜索查询。”

(Prabhakar,2020年)

提供了一个示例来说明即将发生的更改的效果。

借助我们的新技术,我们将能够更好地识别和理解网页上的关键段落。 这将有助于我们浮出水面,而在仅将页面作为一个整体来考虑时,这些内容可能不被视为具有相关性……。”

换句话说,一个很好的答案很可能会在原本很宽泛的主题文档中的单个段落或段落中找到,或者在根本没有太多关注的情况下出现在随机的简介页面中。 例如,考虑许多博客文章和观点,其中许多内容无关紧要或主题混杂,但仍处于越来越杂乱无章的内容不断增长的网络中。

这称为段落索引,但据我们所知不是

“通过索引”公告在SEO社区中引起了一些混乱,一些人最初将更改解释为“索引”。

一个自然的假设是,“通道索引”一词的含义是……错误……“通道”和“索引”。

自然,一些SEO质疑是否将单个段落添加到索引而不是单个页面,但是似乎不是这样,因为Google澄清了即将发布的更新实际上与段落排名问题有关,而不是与索引问题有关。

“我们最近在排名上取得了突破,现在不仅可以索引网页,还可以索引页面中的各个段落,” Raghavan解释说。 “通过更好地理解特定段落的相关性,而不仅仅是整个页面,我们可以找到您正在寻找的大海捞针信息。”

这种变化是关于排名的,而不是每个说话的索引。

这些突破可能是什么,前进的方向是什么?

虽然最初推出时仅会影响7%的查询,但是这一新的段落索引系统的进一步扩展可能比人们最初可能会怀疑的具有更大的内涵。

毫不夸张地说,一旦您开始探索自然语言研究中的过去一年的文献,您就会意识到这种变化,虽然起初相对微不足道(因为毕竟只会影响7%的查询),但实际上有潜力改变未来搜索排名的总体运作方式。

我们将看看这些发展是什么以及接下来会发生什么。

段落索引可能与BERT和其他几个朋友有关……还有更多新突破

希望在探索下面的情况时,更多的事情会变得清晰,因为我们需要更深入地探究并回到BERT,围绕与BERT相关的重大开发的NLP AI的进展,以及去年排名研究的世界。

以下信息主要来自信息检索领域(网络搜索是其基础领域的一部分)的最新研究论文和会议论文集(包括Google搜索工程师在加入Google之前或在Google工作期间的研究)。 )。

在引用论文的地方,我添加了作者和年份,尽管这是一篇在线文章,目的是避免人们夸夸其谈。 这也更清楚地说明了发生的一些重大变化,这些变化表明了到2019年和2020年之前的时间表和进度。

大BERT随处可见

自2019年10月宣布以来,BERT在所有深度学习研究行业排行榜中都以EVERYWHERE为特色。 不仅是BERT,而且还有许多类似BERT的模型,这些模型在BERT变压器结构上或在其基础上进行扩展。

但是,有一个问题。

BERT和类似BERT的模型虽然令人印象深刻,但通常在计算上非常昂贵,因此训练时在财务上非常昂贵,并且要在生产环境中进行大规模全面排名,这使得2018版BERT在大规模商业搜索中成为不切实际的选择引擎。

主要原因是BERT采用了一种依靠自注意力机制的变压器技术,因此每个单词都可以通过同时查看周围的单词来获得上下文。

“对于10万个单词的文本来说,这将需要评估10万x 10万个单词对,或每个步骤要评估100亿个单词对,”根据Google今年的数据。 BERT世界中的这些变压器系统正变得无处不在,但是,BERT的关注机制具有这种二次依赖性问题是众所周知的。

简而言之:在序列中添加的单词越多,在训练过程中需要一次集中关注所有单词组合以获得完整的单词上下文。

但是,在训练这些模型时,问题是“越大越好”。

的确,即使是Google BERT上本次BERT演讲的原始BERT作者之一Jacob Devlin也用幻灯片说出了模型尺寸的效果; “大型模特大有帮助。”

大型BERT型模型似乎在SOTA(最新技术)基准上得到了改善,仅仅是因为它们比以前的竞争者更大。 就像我们知道的“摩天大楼SEO”一样,它是要确定竞争对手已经拥有的东西,然后“在(维度或功能)上另辟floor径”,以仅仅通过做更大或更好的事情来击败。 同样,为了击败以前的模型,仅通过添加更多参数并训练更多数据来开发越来越大的类似BERT的模型。

巨大的模型来自巨大的公司

这些庞大的模型(例如在各种机器学习排行榜上击败SOTA(最先进技术)的模型)中最令人印象深刻的往往是大型技术公司的研究团队的工作,主要是微软(MT-DNN, Turing-NLG),Google(BERT,T5,XLNet),Facebook(RoBERTa),百度(ERNIE)和Open AI(GPT,GPT-2,GPT-3)。

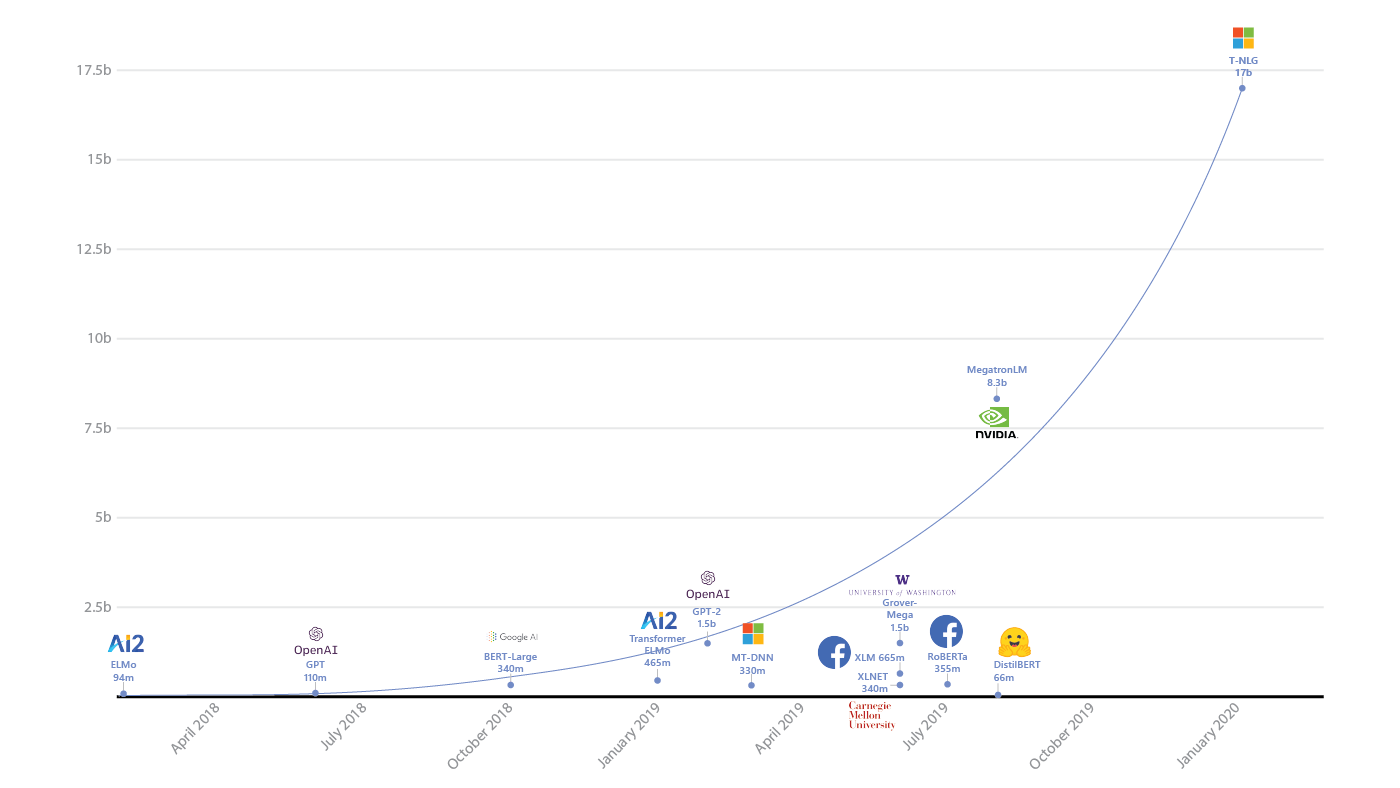

微软的Turing-NLG最近使所有以前的模型相形见as,成为了170亿个参数语言模型。 Bing的自动提示功能和其他搜索功能中使用了该功能。 下图显示了参数的数量,并显示了与其他一些行业模型相比的Turing-NLG。

GPT-3

与OpenAI的1,750亿个参数语言模型GPT-3相比,即使是170亿个参数也算不上什么。

谁能忘记《卫报》关于2020年9月轰动一时的激动人心的GPT-3文章,标题为“整篇文章是由机器人撰写的。 你还怕人吗?”

实际上,这只是大规模的下一句预测,但对于不了解自然语言空间正在发展的外行来说,难怪这篇文章遇到了这样的麻烦。

谷歌T5

2020年2月发布的Google T5(文本到文本传输转换器)(比BERT更新的基于转换器的语言模型)只有110亿个参数。

尽管这是由Google研究小组进行的文本收集培训,但该文本收集由The Common Crawl追溯到2011年的数十亿亿字节的巨大Web爬网组成,并恰当地命名为C4,因为其中有四个C由于其大小,名称为“巨大的清洁爬行语料库”。

但是,大型且令人印象深刻的模型会带来费用。

BERT的价格昂贵(从财务和计算角度而言)

训练SOTA AI模型的成本惊人

在一篇题为“培训SOTA(最新技术)AI模型的惊人成本”的文章中,Synced Review探索了培训一些较新的SOTA NLP AI模型所涉及的可能成本,其数字每小时不等数百(培训可以花费很多小时),以至于要花费数十万美元的总费用来训练一个模型。

这些成本一直是很多讨论的主题,但是它被广泛接受,无论第三方估算的准确性如何,所涉及的成本都是勒索性的

AlchemyAPI的创始人艾略特·特纳(Elliot Turner)(被IBM沃森收购)估计了XLNet的培训成本(Yang等,2019) ,这是Google Brain团队和卡内基·梅隆(Carnegie Mellon)于2020年1月发布的一项合并工作,费用约为245,000美元。

这在Twitter上引发了相当多的讨论,以至于甚至Google AI的Jeff Dean都在推文中加入了插图,以说明Google以可再生能源的形式做出的贡献:

这就掩盖了问题,并且可能是为什么尽管领土扩展,但在2019年Google投入生产时仅对10%的查询使用了BERT。

从计算和财务角度看,生产级别的类似BERT的模型都非常昂贵。

长格式内容和类似BERT的模型面临的挑战

变压器限制

在实际扩展类似BERT的模型时,也存在另一个挑战,这与为了维护单词上下文而可用的序列的长度有关。 其中大部分与转换器架构中上下文窗口的大小有关。

单词上下文的转换器窗口的大小至关重要,因为“上下文”只能考虑该窗口范围内的单词。

欢迎“改革者”

为了帮助改善变压器上下文窗口的可用大小,2020年1月,Google推出了“ Reformer:高效变压器”。

2020年VentureBeat早期发表的一篇题为《谷歌AI语言模型的改革者可以处理小说的整体》的文章指出:“…变压器并不是一成不变的,将其扩展到更大的环境显然可以证明其局限性。 使用大窗口的应用程序对内存的要求从千兆字节到TB级不等,这意味着模型只能摄取几段文字或生成简短的音乐。 因此,Google今天推出了Reformer,这是Transformer的改进版本,旨在处理高达一百万个单词的上下文窗口。”

Google在今年的博客文章中解释了转换器在上下文窗口方面的根本缺陷:“ Transformer的力量来自关注,它通过考虑上下文窗口中所有可能的单词对来理解它们之间的联系的过程。 因此,对于10万个单词的文本,这将需要评估10万x 10万个单词对,或者每个步骤要评估100亿对,这是不切实际的。”

谷歌AI负责人杰夫·迪恩(Jeff Dean)表示,更大的范围将是谷歌未来工作的重点。 他说:“我们仍然希望能够做更多上下文相关的模型。” “像现在这样,BERT和其他模型可以很好地处理数百个单词,但上下文上下文中不能使用10,000个单词。 因此,这是[一个有趣的方向。” Dean在12月告诉VentureBeat。

Google在过去一周关于新段落索引开发的后续澄清推文中也承认,目前的排名系统(甚至是基于变压器或基于重整器的模型除外)通常存在弱点,包括较长的内容:

“通常,我们会评估网页上的所有内容,以确定其是否与查询相关。 但是有时网页可能会很长,或者涉及多个主题,这可能会稀释页面的某些部分与特定查询的相关性……。”该公司表示。

BERT的计算限制目前为512个令牌,这使得类似于BERT的模型对任何比段落更长的时间都不可行。

BERT在2018/2019年无法进行大规模生产

因此,虽然BERT可能是“很不错”的东西,但实际上在2018/2019格式中,作为协助大规模自然语言理解和在网络搜索中进行全面排名的解决方案是不现实的,并且实际上仅用于句子和短语中具有多种含义的查询的细微差别,而且肯定没有任何规模。

但这对BERT来说并不是坏消息

在整个2019年和2020年,为了使BERT类型的技术比令人印象深刻的“不错”有用得多,有了一些重大的飞跃。

长文件内容的问题已经得到解决

大鸟,Longformer和ClusterFormer

由于性能方面的大多数问题似乎都围绕着变压器的二次依赖性及其对性能和费用的影响,因此最近的工作试图将这种二次依赖性转变为线性,其中最突出的就是Longformer:The Long Document Transformer (Beltagy,2020年)和Google的“大鸟” (Zaheer等,2020年) 。

Big Bird论文摘要写道:“所提出的稀疏注意可以处理长度为以前使用类似硬件可能达到的8倍的序列。 由于能够处理更长的上下文,BigBird极大地提高了各种NLP任务(例如问题回答和摘要)的性能。”

值得一提的是,10月中旬,微软研究人员(Wang等,2020)发表了他们关于Cluster-Former的论文。 Cluster-Former模型是Google自然问题“ Long Answer”排行榜上的SOTA。 这两个模型还试图解决长格式内容的限制。

现在,“表演者”重新思考了变压器

同样是在最近(2020年10月),谷歌,剑桥,DeepMind和艾伦·图灵研究所之间的联合工作也发表了,以解决变压器结构总体上的效率和规模问题,该论文发表在题为“重新考虑表演者的注意力” (Choromanski等人) (2020年) ,提出了对注意力机制工作的基本方式的全面回顾,旨在降低变压器类型模型的成本。

同步评论于2020年10月2日对此进行了报道。

但是,这些都是非常非常近期的工作,而且可能太过新以至于无法对通过索引的情况产生暂时的影响(目前),因此它们“可能”不是Google宣布通过索引时所指的突破。 。

诸如Big Bird和ClusterFormer之类的长格式内容模型与BERT等人的长文档在生产搜索中的显着改进之间肯定会存在滞后。

因此,目前看来,自然语言研究人员和搜索引擎必须使用比长格式内容(例如段落)短的序列。

因此,回到目前的状况。

解决NLP模型的未解决领域

2019年和2020年的大部分焦点似乎都集中在解决NLP模型尚未解决的领域上,雅各布·德夫林(Jacob Devlin)在我之前提到的演讲中提到过。 这些是:

- 使现代硬件上的总培训成本与准确性最小化的模型。

- 参数非常有效的模型(例如,用于移动部署)。

- 表示潜在空间中的知识/上下文的模型。

- 表示结构化数据的模型(例如知识图)。

- 共同代表视觉和语言的模型。

尽管列表中BERT周围的多个区域都在工作,尤其是知识图,但对于本文的重点,我们应该继续探索Devlin逐项列出的训练成本和参数效率点。

使BERT更有效和有用

Devlin列表中的第一项已经取得了良好的进展,许多研究致力于创建模型,这些模型可以在生产环境中更经济地使用,并且在生产环境中可能可行。

更有效的模型

到2020年,一波大型模型出现了,几乎同时,一波更高效的,提炼的BERT样模型出现在研究团体中,旨在最大程度地保持有效性,同时减少与效率相关的费用。

DistilBERT,ALBERT,TinyBERT和ELECTRA:最小损耗,最大增益

效率改善的重要例子包括Hugging Face的DistilBERT,Google的AlBERT(精简BERT)和TinyBERT(教师/学生类型的BERT模型),其中知识从大老师BERT转移到小学生BERT(TinyBERT),Google也引入了ELECTRA,它使用了不同类型的面罩技术来显着提高性能,同时又保持了大多数功效。

根据Google AI的说法,“当使用少于1/4的计算量时,ELECTRA可以在GLUE自然语言理解基准上达到RoBERTa和XLNet的性能,并在SQuAD问题回答基准上达到最新的结果。 这些改进是由于采用了比训练BERT模型时掩盖15%的单词更有效的方法,这在计算上非常昂贵。”

前面提到的每个修改都比原始BERT模型有效得多,有效性损失最小。

研究工程师和免费数据的“大军”

进步的另一个推动力是整个研究社区的形式(从字面上)来应对提高机器语言理解的挑战。

但是愿意的参与者需要数据来训练更好的模型。

正如Devlin在演讲中所说的那样,他相信“ NLP的近期改进将主要在于对“免费”数据的巧妙利用。”

虽然有越来越多的免费数据集资源可供数据科学家使用(例如Kaggle在2017年被Google收购); 可以说是最大的数据科学家社区,拥有数百万注册用户的机器学习竞赛。 但是,用于“真实”自然语言研究的“真实世界”类型数据,尤其是基于真实日常网络和查询的数据,却并非如此。

尽管如此,“免费”自然语言数据的来源正在增长,尽管现在有数不胜数,但许多提供给自然语言研究社区的数据是由搜索引擎**的。

MSMARCO(微软)

自2016年以来,MSMARCO数据集一直是微调模型的主要训练练习之一。

微软的MSMARCO最初是来自真正的匿名Bing搜索引擎和Cortana助理查询提交的100,000个问题和答案的数据集,但现在已扩展了十倍,超过了1,000,000个问题和答案。 此外,MSMARCO的功能已扩展到包括其他培训任务,这些培训任务超出了一般自然语言理解和问答任务的范围。

Google自然问题(Google)

像MSMARCO一样,Google拥有自己的自然语言问答数据库,其中包括对Google搜索引擎的真实用户查询,以及排行榜和要执行的任务,称为“ Google Natural Questions”。

“问题包括发给Google搜索引擎的真实的匿名汇总查询。 简单的启发式方法用于从查询流中过滤问题。 因此,问题是“自然的”,因为它们代表了寻求信息的人们的真实查询。”

(Kwiatkowski等,2019)

在Google自然问题上,研究人员必须训练他们的模型以阅读整个页面,然后才能从Wikipedia的单个段落中找到长答案和短答案。 (下面的可视化)

TensorFlow C4数据集–巨大的清洁抓取

较新的数据集是前面介绍T5时提到的C4(普通抓取的巨大清理抓取)。 尽管最初的BERT的语言预训练是针对英语Wikipedia和BookCorpus的25亿个单词(8亿个单词),但来自Wikipedia的语言并不代表日常自然语言,因为很少有网络由相同的半结构化良好结构组成,链接结构。 C4将通过现实世界自然语言进行的预训练带入了更加类似于现实的东西,并被用来对Google的T5模型进行预训练。

C4 Clean Colossal Crawl Dataset由数十亿页的The Common Crawl(自2011年以来的“真实网络”的大量示例)的“巨大” PB级爬网组成,并清除了样板(脏话,JavaScript通知,代码和其他消除“噪音”的干扰)。 同样,在清理后使数据集可供其他人学习。

NLP的许多研究已转向段落和排名

在过去几年中,段落检索和排名已成为最受欢迎的研究领域之一。

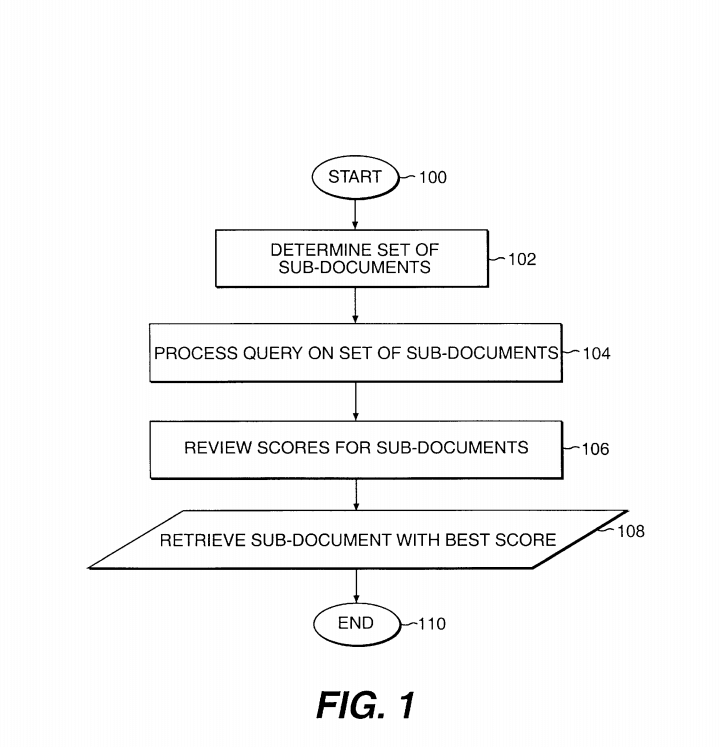

这样,在信息检索中检索文档的一部分,AKA段落检索或子文档检索并不是什么新鲜事。 参见下图,该图示例出自1999年的信息检索子文档检索系统专利。 (Evans,1999年)

我们还可以找到2008年或更早的关于段落排名的IR研究论文,例如“使用文档段落图对搜索结果重新排名” (Bendersky等,2008) ,当然还会有更多。

我们还可以看到,段落检索是2018年初在YouTube上的视频研究的活跃领域:

您将在上面的屏幕截图中看到所有“段落通过特征”,它们很大程度上是基于实体,n-gram,查询词(关键字)以及单词,单词,单词的“计数”。 关键字无处不在。

但这是在2018年6月,因此在2018年6月至今的重要功能权重之间可能存在很大差异。

…那是在BERT之前。

BERT一直为通过排名研究的热情做出了巨大贡献,这很可能是由于上述与BERt变压器架构效率低下和长度限制有关的问题。

“正如我们已经广泛讨论的那样,出于多种原因,BERT遇到输入序列长于512个令牌的麻烦。 当然,显而易见的解决方案是将文本分成段落。” (Lin et al,2020)

但是,还有一个原因使段落排名成为BERT研究人员的热门机器学习活动。

MSMARCO的通过排名任务和排行榜

自2018年10月以来,一直在MS MARCO和相关排行榜上进行通过排名任务,吸引了语言研究人员的大量参赛作品,包括Facebook,Google,百度和微软等大型科技公司的研究人员。

确实,仅在过去的一周中,正如MARCO女士在Twitter上宣布的那样,由于该领域目前进展有限,他们很快将退出其问答任务排行榜,并强调他们将继续保持Passage Rank任务,因为这是重点现在。

在MS MARCO段落排名任务中,提供了880万个段落的数据集。

根据MS MARCO网站:

“使用Bing搜索引擎的最高级版本从真实的网络文档中提取导出数据集答案的上下文段落。 如果可以汇总答案,则查询的答案是人为产生的。”

通过等级任务分为两部分。

- 段落重新排名:给定BM25检索的1000个最佳段落,按相关性重新排列段落。

- 段落完全排名:给定一个880万个段落的语料库,生成按相关性排序的前1000个候选段落。

一些突破

现在,我们可以很好地了解Google过去一周在Search On中提到的排名突破之处。

Google所指的突破不仅可能是段落排名本身,还在于段落排名和其他“新颖”发现方面的突破,这些发现是段落检索研究领域大量活动的副产品,以及来自Google的新创新这项研究与Google当前的排名方法(例如,使用TensorFlow进行学习排名(LeToR))相结合,加上他们自己的研究团队的大量发展(专门针对通过排名)以及整个AI行业的进步。

例如,ROBERTA(训练有素的BERT)和ELECTRA (Google,2020)以其更有效的掩蔽技术。 还有其他重大突破,我们很快就会提出。

以同样的方式,研究社区全面加入了问答和自然语言理解的行列,通过反复的改进产生了BERT和朋友,因此现在也将重点放在提高排名的效率和效果上,尤其着重于段落。

毕竟,在BERT的约束下,通过量较小,因为很容易将较长的文档分成几部分。

而且看起来确实有非常重大的发展。

为了更全面地了解进度,我们需要查看排名系统作为整体行业标准的工作方式,因为它看起来并不像从索引中一次获取那样简单。

两阶段排名系统

在两个阶段的排名中,首先是完整排名(所有文档的初始排名),然后是重新排名(第二阶段,只是从第一阶段中选择了一些最佳结果)。

在信息检索(和Web搜索)中,分两阶段进行的排名是首先使用简单的经典检索算法(例如BM25)或查询扩展算法,学习排名算法或简单的分类器来检索大量文档方法。

然后,可以使用神经重新排序器,以更高的精度和更多的资源执行第二阶段,该阶段比第一阶段检索到的结果多。

我们不必深入研究文献就可以找到两个(或多阶段)阶段排名系统作为行业标准的确认。

“最先进的搜索引擎使用排名管道,其中高效的第一阶段使用查询从文档**中获取一组初始文档,并且一个或多个重新排名算法可以改善和简化排名。”

(戴,2019年)

“两步文档排名是新标准,其中通过经典信息检索方法进行初始检索,然后再进行神经重新排名模型。 通过使用基于变压器的模型作为重新分级,例如BERT,可以达到最佳性能。”

(Sekulic等人,2020年)

“在对文档集进行排名的两阶段学习之前,通常是使用经典且简单的无监督词袋法(例如BM25)从**中检索出来的。”

(Dang,Bendersky和Croft,2013年)

请注意,BM25代表“最佳匹配25算法”,通常比讨论最多的TF:IDF更受青睐。之所以如此命名,是因为它是特定排名类型算法的第25次尝试,是当时任务的最佳匹配(琐事)。

虽然我们不能确定Google和其他搜索引擎当然会以任何方式使用BM25,但是对于那些有兴趣学习ElasticSearch的人来说,它可以很好地概述BM25算法。 但是,许多信息检索讲座仍在一定程度上讲授该知识。

在生产搜索的情况下,它可能比BM25总体而言要先进得多,但可能会在第二阶段而不是最初的获取中使用更先进,更昂贵的资源。 Bing的Frederic Dubut确认Bing在其大部分搜索引擎中使用了LambdaMART,这是一种“学习排名”算法(尽管他没有评论该排名是处于排名的第一阶段还是第二阶段,还是处于所有排名阶段)。 由Google研究人员撰写的论文指出:“ LambdaRank或基于树的变体LambdaMART一直是将排名指标纳入学习过程的最有效算法之一。” (Wang et al,2018)

要点是,由于有更多的资源(容量/财务),它可能比研究中使用的系统更强大,但是原理(和基础算法)保持不变。

一个警告是,一些商业搜索引擎可能还会使用“多阶段”排名神经模型。

在谈到多阶段排名流程时,Nogueria等人在2019年写道:“已知的生产部署包括Bing网络搜索引擎(Pedersen,2010年)以及阿里巴巴的电子商务搜索引擎。”

他们补充说:“尽管今天经常被掩盖,但大多数神经排名模型仍然存在。 。 。 实际上,它们是对模型进行重新排序,从某种意义上说,它们是对候选文档列表的输出进行操作,通常由“单词袋”查询生成。 因此,如今使用神经模型进行文档检索已经使用了多阶段排序,尽管只有一个重新排序阶段的形式很贫乏。”

两阶段索引不是两阶段排名

进一步澄清。 我们知道两个阶段的索引编制/渲染,并且Google提供了有关两个阶段的索引编制情况的大量信息,但这不是两个阶段的排名,也不是两个阶段的索引。

两个阶段的排名完全不同。

第一阶段两阶段排名:完整排名

在“两阶段学习排名” (Dang等人,2013年)中,首先基于包含多个功能和查询扩展的学习的“相关性模型”对文档列表进行排名,然后训练该模型基于此“相关性模型”在第一个召回阶段。

两阶段排名的第一阶段实际上是关于检索尽可能多的潜在相关页面。 第一阶段可能会扩展BM25之类的东西,这是一种基于tf(术语频率)的方法,具有各种查询扩展术语以及分类功能,因为根据Vang等人的说法(2013年),“最好在初始检索中获取更多文档,因此以避免在第二阶段丢失重要且高度相关的文件。” (Vang等人,2013) 。

关于“学习排名”和扩展查询集以包括查询扩展的主题,Vang等人写道; “由于在最初的第一阶段召回中包含了更多文档,因此该查询扩展模型被认为优于简单的词袋算法(例如BM25)。” (Vang等,2013)。

两阶段学习排名信息检索

关于“学习排名”:

“我们首先使用一组有限的文本功能(包括加权短语,邻近度和扩展术语)来学习整个检索**的排名功能。 然后使用此功能来检索文档的最佳可能子集,并使用较大的一组与查询和文档相关的功能来训练最终模型。”

(Vang等,2013)

尽管2013年的论文比较陈旧,但更重要的是,由于两阶段系统仍然是“行业标准”,因此进步会有所改善。

第二阶段的第二阶段排名:重新排名

从检索到的文档列表中,对指定的top-X数量的文档执行第二遍,从检索到的文档列表中将其称为top-K,并使用机器学习技术对其进行微调以提高精度。 在信息检索论文中,您经常会看到术语P @ K(精度为K),指的是相对于相关的“黄金标准”或“基本事实”(K为数字,例如, P @ 10表示相对于检索到的前10个结果中的查询而言,被判定满足用户信息需求的准确结果数。

在此信息检索讲义幻灯片中,很好地解释了评估指标,例如P @ K(还有许多其他指标)。

两阶段排名的第二阶段是精度更为重要,并且要消耗更多的资源,同时还可能添加更多相关性度量以真正将黄金排在首位。

至关重要的是,更精确地对选择要包含在第2阶段中的那些文档进行排名的重要性是至关重要的,而对排名较高的结果的准确性(更重要的是),因为搜索引擎用户看到这些结果的可能性很高。

正如谚语所说,“只有SEO看起来超出搜索结果的第二页”。

在“用于信息检索排名的两阶段学习”中,Dang等人说:

“在运行时,响应用户查询,再次使用阶段A模型来检索一小组高度排名较高的文档,然后由阶段B模型对其进行重新排名。 最后,重新排序的结果将呈现给用户”

(Dang等,2013)

总而言之,效率和有效性相结合是两个阶段排名过程的主要驱动力。 在最重要的文档上使用计算量最大的资源来获得更高的精度,因为这是最重要的。 完整排名是第一阶段,重新排名是第二阶段,目的是对从完整**中检索到的前K个词进行改进。

顺便说一句,这也可能就是为什么Google的Danny Sullivan在5月的一条推文中说:“如果您在前10名中,那么您做的事情就正确了。”

因为,在重新排名的“精确”阶段中,前10名可能是Top-K的最重要部分,因此将针对这些结果进行最大的功能和精确的“学习”。

提高排名的第二阶段(精确度)已成为重点

鉴于排名第二阶段对准确性的重要性,大多数有关排名改进的研究都集中在此阶段-重新排名阶段。

暂时充分利用BERT

我们知道BERT的2018/2019格式受到限制。 尽管出现了较小的模型,但尤其是受序列长度/上下文窗口限制以及费用的限制。

如何使BERT更好地处理“细微的”歧义需求,使其仅在句子级别的网络搜索中胜于“必备”,并使其具有有意义的用途? 许多研究人员也可以从中受益吗?

BERT被重新用作段落排名和重新排名

啊哈... BERT作为段落排名。

再一次加强了BERT的限制和理想的当前使用:“出于多种原因,BERT的输入序列长于512个令牌的问题。 显而易见的解决方案,当然,这也是今年的文本分成段落,”每林等。

研究和开发的最大突破领域之一是重新定义BERT作为重新排名者的用途,最初是由Nogueria和Cho在2019年发表在其论文《与BERT进行排名重新排名》中,然后是其他。

正如Dia,2019年在2019年的一篇论文中指出的那样:“ BERT受到IR的广泛关注,主要集中在将其用作黑匣子重新排序模型来预测查询文档的相关性得分。”

Nogueira&Cho在其2019年的论文《使用BERT进行排名重新排序》中说,他们“描述了BERT的简单重新实现,用于基于查询的段落重新排名。 我们的系统在TREC-CAR数据集上是最先进的,并且在MS MARCO段落检索任务的排行榜中排名第一,在MRR @ 10方面比以前的先进水平高27%。”

“我们已经将BERT的简单改型描述为段落重排,它已经在两个不同的任务(TREC-CAR和MS MARCO)上成为最新技术。”

我采访了Mohammad Aliannejadi博士,他是信息检索领域的几篇论文的作者,也是阿姆斯特丹大学信息检索的博士后研究员,探讨了自然语言,移动搜索和对话搜索。

Aliannejadi博士说:“目前,作为重新排名的BERT更实用,因为全面排名非常困难且昂贵。” “而且,有效性的提高并不能证明效率的下降。”

他继续说:“使用BERT进行全排名需要大量的计算资源。”

BERT和段落

随后,段落重新排名(以及越来越多的BERT与段落重新排名)现在成为信息检索和机器学习语言研究界最喜欢的2020年主题之一,并且该领域正在取得重大进展,尤其是与其他语言相结合时AI研究围绕效率,规模和两阶段排名改进进行了改进。

段落和BERT(目前)齐头并进

只需查看Lin等人最近出版的书“用于文本排名的预训练变形金刚:BERT and Beyond”(Lin等人,2020年)中的目录,即可看到段落排名对最近的“ BERT世界”产生的影响”,其中291条提到了段落,正如胡安·冈萨雷斯·维拉指出的那样:

Google研究和文章排名/排名

自然,Google Research拥有一支团队,该团队加入了挑战以提高文章的排名和排名(Google TF-Ranking团队),在MSMARCO的排行榜上进行竞争,并通过反复改进的模型(TFR-BERT)进行了多次修订。

TFR-BERT基于题为“在TF-Ranking中与BERT学习到等级”的论文(Han等人,2020年) ,其最新修订版于2020年6月。有关作者的文章排名,特别是MS MARCO文章的全部排名和重新排名任务,”作者写道。

“ ...我们为文件和段落排名提出了TFR-BERT框架。 它结合了预训练语言模型(例如BERT)和按等级学习的方法的最新发展。 我们对MS MARCO段落排名任务的实验证明了其有效性。”

TFR-BERT – BERT集成模型-Google的BERT集成

Google Research的最新BERT'ish模型已演变为BERT和其他混合方法的**-其他模型的各个部分的组合,或者甚至组合了不同的完整模型,方法和增强功能。

许多BERT作为段落排名和排名更改者实际上是“ SuperBERT的

由于BERT研究领域中的许多代码都是开源的,包括Google,Microsoft和Facebook等大型科技公司的大量代码,因此那些寻求改进的人可以构建集成模型来制作“ SuperBERT”。

2020年,在语言模型领域和排行榜中涌现出了此类“ SuperBERT”模型。

以这种方式使用BERT可能与仅在10%的查询中使用的BERT不同。 这可能是为了完成一些简单的任务,例如对非常短的文本和句子进行歧义消除和命名实体确定,以了解查询词中两种可能含义之间的区别。 实际上,在题为“ Sentence-BERT:使用暹罗BERT网络的句子嵌入”的论文中,存在一个名为SentenceBERT的BERT (Reimers&Gurevych,2019年) ,但这并不意味着在2019年提到的10%的查询中使用了SentenceBERT。当然。

要点是,BERT的段落排名完全被BERT用来在两个阶段的训练中增加上下文含义。 进行全面排名然后重新排名,并且使用情况可能与2019年的生产搜索中实现10%的实施方式大不相同。

SEO社区的一位朋友(Arnout Hellemans)以“ SuperBERTs”为主题,将我的狗BERT称为“ SuperBERT”,因此添加她的照片似乎是一个适当的借口。

在TF排名中与BERT一起学习排名(han等,2020)

Han等人(2020年)解释了将原始BERT和TF-Ranking模型整合到一个**的附加集成,该模型通过向MS MARCO段落排行榜提交了五种不同的提交,将ELECTRA和RoBERTa与BERT和TF-Ranking方法相结合。

TF-Ranking被描述为“ TF-Ranking:一种用于学习到排名的可伸缩TensorFlow库” (Pasumarthi等,2019)

“本文介绍了一种用于文档排名的机器学习算法,该算法首先使用BERT对查询和文档进行编码,最重要的是,使用TF-Ranking(TFR)构建的排名学习(LTR)模型应用于进一步优化排名效果。 在公开的MS MARCO基准中,这种方法被证明是有效的。”

(Han et al,2020)

“为了利用最近开发的预训练语言模型,我们最近集成了RoBERTa和ELECTRA。”

(Han,Wang,Bendersky,Najork,2020)

您可能还记得ELECTRA是由Google发布的,而RoBERTa是由Facebook发布的。

但是,我们还可以从论文摘录中看到提到的其他元素,以及RoBERTa,BERT,TF-Ranking和ELECTRA。 提及DeepCT。

根据“与BERT在TF排名中学习排名”论文:

“ Google的TFR-BERT向MS MARCO Passage排名排行榜提交的5份报告如下:

- 提交#1(重新排序):TF排名+ BERT(Softmax损失,列表大小6,200k步)

- 提交#2(重新排序):TF-排名+ BERT(逐点,成对和按列表损失的**)

- 提交3(完整排名):DeepCT检索+ TF排名的BERT乐团

- 提交#4(重新排名):BERT,RoBERTa和ELECTRA的TF排名乐团

- 提交#5(完整排名):BERT,RoBERTa和ELECTRA的DeepCT + TF排名合奏

早期提交的只是BERT和TF-Ranking(TensorFlow排名),而RoBERTa和ELECTRA后来又被添加到另一个排行榜提交中,最大的收获似乎是添加了DeepCT,DeepCT在完整排名通过排名的提交3和5之间有了明显的改进。任务,尽管论文摘要中未提及Deep-CT。

Google的SuperBERT集成模型(从TFR-BERT演变而来)在MS MARCO的全排名和重新排名段落排行榜上均表现良好。

您现在可以在这里(2020年10月)在下面图像中标题5的位置上看到它:

BERT,ROBERTA和ELECTRA的DeepCT + TF排位乐团(1)韩曙光,(2)戴Zhu云,(1)王璇辉,(1)Michael Bendersky和(1)Marc Najork – 1)Google Research,(2)卡内基·梅隆–纸和密码

另请注意,尽管没有在原始论文中列出,但Dai从4月起已被列入排行榜的Google TF-Ranking团队成员中。

深入研究“在TF-Ranking中使用BERT学习排名”的正文中,我们看到以下内容:“我们发现DeepCT大大提高了BM25结果的重新排名,并且进一步结合了BM25和DeepCT重新排名都带来了更多收益。”

Han等人继续研究模型修订,包括DeepCT,他继续说道:“通过提交第3项,我们在2020年4月10日的排行榜上取得了第二好的整体表现。通过最近提交的第5项,我们进一步改善了先前的表现,并在2020年6月8日之前获得了排行榜上的第三佳表现(介于此之间的数十个新的排行榜提交者)”

同样,重要的是要记住,在“完全排名”任务上而不是在“重新排名”任务上有明显的改进。 请注意,两个“全排名”任务都包括DeepCT,但“重新排名”任务不包括。

- 5 – BERT,ROBERTA和ELECTRA的DeepCT + TF-Ranking乐团(1)韩曙光,(2)戴Zhu云,(1)王宣辉,(1)Michael Bendersky和(1)Marc Najork – 1)Google Research,( 2)卡内基·梅隆-纸和密码。 完整排名2020年6月2日

- 11 – DeepCT检索+ TF-Ranking BERT组合1)韩曙光,(2)戴Dai云,(1)王璇辉,(1)Michael Bendersky和(1)Marc Najork –(1)Google Research,(2)卡内基·梅隆大学–论文[Han等。 '20]代码。 完整排名2020年4月10日

- 14 – BERT,ROBERTA和ELECTRA的TF-Ranking乐团(1)韩曙光,(2)戴韵云,(1)Wang Xuanhui,(1)Michael Bendersky和(1)Marc Najork – 1)Google Research,(2)卡耐基梅隆大学–纸和密码。 重新排名2020年6月2日

- 25 – Google Research的TF-Ranking小组(韩曙光,王宣辉,Michael Bendersky和Marc Najork)– TF-Ranking + BERT(点对,成对和按列表损失的组合)[Han等。 '20]和[代码]。 重新排名2020年3月30日

深度CT

DeepCT似乎是一种秘密的调味料成分,在Google TF-Ranking Research团队的MS MARCO完整排名任务排行榜中快速连续取得了一些重大成就。 回忆完整排名阶段涉及两阶段任务的第一阶段。

就MS MARCO而言,它是所提供的880万篇论文的排名,其重新排名与微调从最初的第一个排名阶段获得的前1000个结果有关。

因此,DeepCT与此处的第一阶段(第一阶段)的完整排名有所不同。

那么DeepCT到底是什么,它不仅对排行榜排行榜有重要意义?

DeepCT代表“深度上下文化术语加权框架”,并在题为“第一阶段通道检索的上下文感知术语加权”的论文中提出。 (戴,2020年)

DeepCT的发明者Dai将该框架描述为:“ DeepCT,一种新颖的上下文感知术语加权方法,可以更好地估算第一阶段词袋检索系统的术语重要性。”

但这并不能真正做到正义,因为DeepCT的功能远不止第一个犯罪嫌疑人。

DeepCT段落内容更丰富,可替代tf(学期频率),并通过DeepCT改善了第一阶段的排名

DeepCT的发明者Dai展示了DeepCT不仅可以改善第一阶段的排名结果,并为段落中的术语添加上下文感知,而且可以与BERT Re-ranker(在第二阶段)结合使用(Bert被Nogueria用作重新排名)和Cho,2019年)在提高段落“按意图对齐”排名结果的准确性和效率方面非常有效,并显示了在不对现有体系结构进行大量修改的情况下具有扩展到生产环境的潜力。

确实,DeepCT在通过索引过程中是很有效的,这是一个排名过程,但是在DeepCT的情况下,涉及“索引”元素,但在SEO空间中并不如此(有关DeepCT主题的论文都引用了参考文献索引)。

目前,DeepCT的使用仅限于默认的BERT 512令牌,但这是段落的理想选择,无论如何,段落都是文档的一部分,因为它们实际上只是切碎的文档。 因此,普通文档成为一组段落,其序列通常完全在BERT的512令牌范围内。

再次重申Lin的话:“正如我们已经广泛讨论的那样,出于多种原因,BERT遇到输入序列长于512个令牌的麻烦。 当然,显而易见的解决方案是将文本分成段落。”

为什么DeepCT如此重要?

虽然DeepCT目前受限于BERT的512令牌限制的限制,因此受到限制,但DeepCT可能构成排名“突破”。

重要的是,DeepCT不仅寻求提供上下文感知的段落排名解决方案,而且开始围绕长期建立的排名和检索模型以及系统解决一些长期存在的信息检索行业问题。 这些发展可能远远超出了DeepCT和我们今天关注的段落索引更新的局限性,尤其是当效率和上下文窗口的其他改进已开始在类似BERT的系统和转换器中解决时。

段落中词频(tf)的问题

DeepCT试图解决的第一个问题与第一阶段排名系统中tf(词频)的使用有关。

正如Dai指出的那样:“最先进的搜索引擎使用排名管道,其中高效的第一阶段使用查询来获取初始文档集,并使用一个或多个重新排名算法来改善和简化排名。 通常,第一阶段排序器是一个词袋检索模型,它使用词频(tf)来确定词在文档中的特定重要性。 但是,tf不一定表示一个术语对于文档的含义是否必不可少,尤其是当频率分布平坦时(例如,段落)。 本质上,tf忽略了术语及其文本上下文之间的相互作用,这是估计特定于文档的术语权重的关键。”

Dai认为,“经常出现”一词在给定的段落内容中并不意味着“具有相关性”,同时也证实了“词袋式”方法在传统中具有的基本作用,同时强调了当前系统的缺点。

Dai表示:“词袋在现代搜索引擎中起着根本性的作用,因为它的效率和产生详细词匹配信号的能力。” “大多数词袋表示和检索模型都基于词频(tf)使用词权重,例如tf.idf和BM25。 但是,频繁出现并不一定会导致语义上重要。 识别文本中的中心词还需要考虑每个词的含义及其在特定上下文中的作用。”

Dai将基于频率的术语权重描述为一种“粗略的工具”(尽管它们已经取得了巨大的成功),因为tf不能区分对于整个文本含义至关重要的单词和对于整个文本含义都不重要的单词,尤其是在段落和句子,并提出需要在文本内容的上下文中理解单词的含义,这是一个“关键问题”。

Dai和Callan在2019年写道:“基于频率的术语权重取得了巨大的成功,但它们是一个粗略的工具。术语频率不一定表明术语对文本含义的重要性还是核心意义,特别是在频率分布是平坦的,例如在句子和短段落中”

Dai进一步指出:“要估计单词在特定文本中的重要性,最关键的问题是生成特征来表征单词与文本上下文的关系。”

多阶段排名系统的问题

第二个问题与第一阶段排名系统中的效率和计算成本有关,随后,深度学习研究的重点集中在重新排名(在多阶段情况下,排名的微调,第二或以后阶段)排名系统),这是由于深度学习的计算费用所致,而不是完全排名(最初的第一阶段)。

“大多数第一阶段的排名是使用词频信号的较旧但效率很高的词袋检索模型,并且有关排名的许多研究工作都集中在排名的后期–精细调整阶段。”戴在2019年说。

Dai建议,与第一阶段排名相关的计算(以及随后的财务)成本限制了复杂深度学习的使用,否则可能会克服与段落中其他周围文本(单词的上下文)有关的术语“缺乏中心”的关注。

“经典术语频率信号无法分辨文本是围绕术语集中还是在讨论某个主题时仅提及该术语。 在复杂的功能和模型过于昂贵而无法应用的第一阶段全收集排名中,这个问题尤其困难。

我们知道,对排名第一阶段的改进是“信息检索的两阶段学习进行排名”研究的基本原理。 即使如此,他们仍然承认,有关排名的绝大多数研究都在第二阶段(重新排名,因此,他们的工作动机被设计为使用更好的微调(例如查询扩展技术)以更好的初始收益率改善第一阶段(Vang等,2013) 。

可能还有许多其他人试图进一步解决这一第一阶段的排名改进,但是由于上述原因,围绕着排名靠前的前K个结果概率的重要性,重点当然已经集中在第二阶段计算/财务费用。

即使将BERT重新用作论文段落,并且研究人员也热衷于遵循BERT对段落进行重新排名的方式,对第二阶段结果的关注也一直在继续。

改善排名的第一阶段并在段落中获得单词的上下文

DeepCT力图同时解决这两个问题。

DeepCT改善了第一阶段的排名

Dai与DeepCT的合作侧重于检索的第一阶段,同时也极大地帮助了下游的重新排名阶段。

“由于神经模型的复杂性,以前的大多数神经IR研究,包括最近利用BERT进行IR的研究,都集中在重新排序阶段。 我们的工作增加了改进现有第一阶段排名的能力。 更准确的第一阶段文档排名为下游重新排名提供了更好的候选者,从而提高了端到端的准确性和/或效率。”

“尽管在开发用于IR的更好的神经排名模型方面已经取得了很大的进步,但计算复杂性通常将这些模型限制在重新排名阶段。 DeepCT成功地将文本理解能力从一个深度神经网络转换为简单的信号,这些信号可以被早期排名系统有效地利用,并提高其性能。”

迪亚(Dia),2020年

使用BERT的术语频率的新选择– tfDeepCT

在排名的第一阶段,Dai还着重于对段落中的单词进行更多的上下文理解,而不仅仅是对它们的count(tf)的理解。

Dai提出了tf词频的另一种选择,其中包含“上下文深度词法加权框架”的一部分,称为“ tfDeepCT”。

tfDeepCT不仅可以计算术语频率,还可以识别段落中单词的深层上下文含义和上下文。

DeepBERT使用BERT表示法,根据段落的上下文,根据单词的中心性和对主题的重要性,为单词分配重要性得分。 DeepCT将较高的权重分配给重要术语,并抑制段落中较低的重要性或偏离主题的术语。

然后将这些权重分配给一个普通的反向索引,不添加任何新帖子,而是替换为tfDeepCT(由BERT的变压器注意架构认为的段落中基于其上下文重要性的加权术语)。

深度CT索引

这称为DeepCT-Index。

“ tfDeepCT用于替换倒排索引中的原始tf。 可以通过主流的词袋检索模型(例如BM25)或查询似然模型来搜索新索引DeepCT-Index。 预期上下文感知术语权重tfDeepCT会将检索模型偏向段落中的中心术语,从而防止检索到离题段落。 DeepCT-Index与典型倒排索引之间的主要区别在于,术语权重基于tfDeepCT而不是tf。 该计算是离线完成的。”

(戴,2020年)

重要提示–这并不意味着这是新的文档索引编制情况。 段落索引是关于段落排名的。 关于总体上即将通过的段落索引,Google已明确表示,新的段落索引更改即将与排名更改相关,而不是文档的索引更改。 根据Google最近的澄清,将不会对段落以及文档进行索引,也不会对其进行索引。

DeepCT-Index(如果使用的话)似乎只是建议在现有索引上简单地增加替代等级权重,但是用tfDeepCT代替tf作为段落。

Dai在DeepCT的相关文献中也明确指出“没有创建新的发帖列表”。

而且还提到了将DeepCT用于段落索引:“第3节介绍了深度上下文术语加权框架(DeepCT),将其用于段落索引(DeepCT-Index)。”

重要提示—我想说一下DeepCT-Index是文献中DeepCT框架的核心部分。 Google研究部在致谢部分以及整篇论文的研究论文“在TF排名中与BERT一起学习排名”中都认可了DeepCT的使用。

“我们要感谢卡耐基梅隆大学的戴竹云分享了她的DeepCT检索结果。”

( Han等,2020)

DeepCT还是当前提交给MS MARCO段落排名排行榜的完整排名的当前研究模型提交的一部分。

但是,这并不意味着它已经在生产中,也不会在生产中。 但是它确实显示了希望和新的有趣的方向,不仅是通过将带有段落排名的BERT用于更大的上下文搜索,而且是为了更有效,更有效的“上下文感知”,可以改善整体搜索效果,因为如果实施,它可能会导致整个端到端排名系统上将使用更大的规模资源。

考虑到最近在论文排行榜上获得的重大成果,以及Dai在DeepCT框架周围发表的论文中报告的结果,这一点就更是如此。 DeepCT的发明人现在也加入了Google TF-Ranking团队,并在最近提交的MS MARCO段落排行榜上列出了模型。

DeepCT在当前的TFR-BERT研究模型和Dai的论文结果中似乎克服了一些传统挑战,这些挑战可以看作是“排名突破”。

回想一下上周Google的Prabhakar Raghavan的Search On事件,当时宣布“段落索引”并说:“我们最近在排名方面取得了突破。”

DeepCT听起来可能会在排名上取得重大突破。

那么DeepCT如何工作?

DeepCT似乎没有提议在信息检索/排名的第一阶段使用术语频率,而是提议用tfDeepCT代替术语频率(TF)。 使用DeepCT,单词的上下文含义被识别为通过BERT转换器使用深度上下文表示法来简单地计算段落中提到关键字的次数的替代方法。

即使在上下文中的重要单词被较少提及,它们在上下文中的权重也会更高,并且在段落或特定上下文中给定单词的上下文时,会给重要性得分分配一个分数,因为单词在不同的时间和不同的场景中具有不同的含义。 文章和主题中较重要的单词(中心术语)的重要性得分较高,而次重要的单词的得分较低和/或完全偏离主题(如果它们偏离主题或对主题的重要性无贡献)通道。

对于“在主题上”的单词产生了强烈的偏见,而对“在主题之外”的单词却产生了抑制。

用1953年路德维希·维特根斯坦的话来说:“单词的含义是它在语言中的使用。”

尽管我在后面的内容中添加了一些评论,但由于我对DeepCT的新主题和复杂主题的了解有限,我不想扭曲DeepCT的技术说明中的含

本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容,一经查实,本站将立刻删除。如若转载,请注明出处:http://www.botadmin.cn/sylc/10393.html